Neue Werkzeuge gegen Hass im Netz

Zwei Projekte der USTP entwickeln Strategien, wie digitale Räume durch KI und Zivilcourage sicherer werden.

Der Kampf gegen Hassrede im Netz gehört zu den großen Kommunikationsfragen unserer Zeit. Während Social-Media-Plattformen mit Sperren und Löschungen arbeiten, verfolgen Forschende an der University of Applied Sciences St. Pölten (USTP) deutlich differenziertere Ansätze. Zwei aktuelle Projekte zeigen, wie technologische Innovation und gesellschaftliche Verantwortung zusammenfinden und welche Lücken die Branche bislang offen gelassen hat.

Gegenrede statt Rückzug

Im Zentrum des Projekts Counter Speech: Young People Against Online Hate steht die Idee, junge Menschen nicht nur zu schützen, sondern zu befähigen. Die Forschenden analysieren, wie Gegenrede funktioniert, welche Formen tatsächlich Wirkung zeigen – und wie automatisierte Systeme diesen Prozess stützen können.

Djordje Slijepcevic vom Institut für Creative\Media/Technologies beschreibt den Ansatz als „citizen-generated counter speech“. Gemeint ist: Die Community soll problematischen Kommentaren nicht mit Schweigen oder Rückzug begegnen, sondern mit aktiver, konstruktiver Reaktion. KI-gestützte Modelle erkennen dabei Formen von Hass- und Gegenrede und machen positive Muster sichtbar. Für die Kommunikationsbranche ist dieser Ansatz insofern spannend, als er die Dynamik digitaler Diskurse nicht über Moderation, sondern über mündige Nutzerinnen und Nutzer stärkt.

Eine App, die Gegenrede trainiert

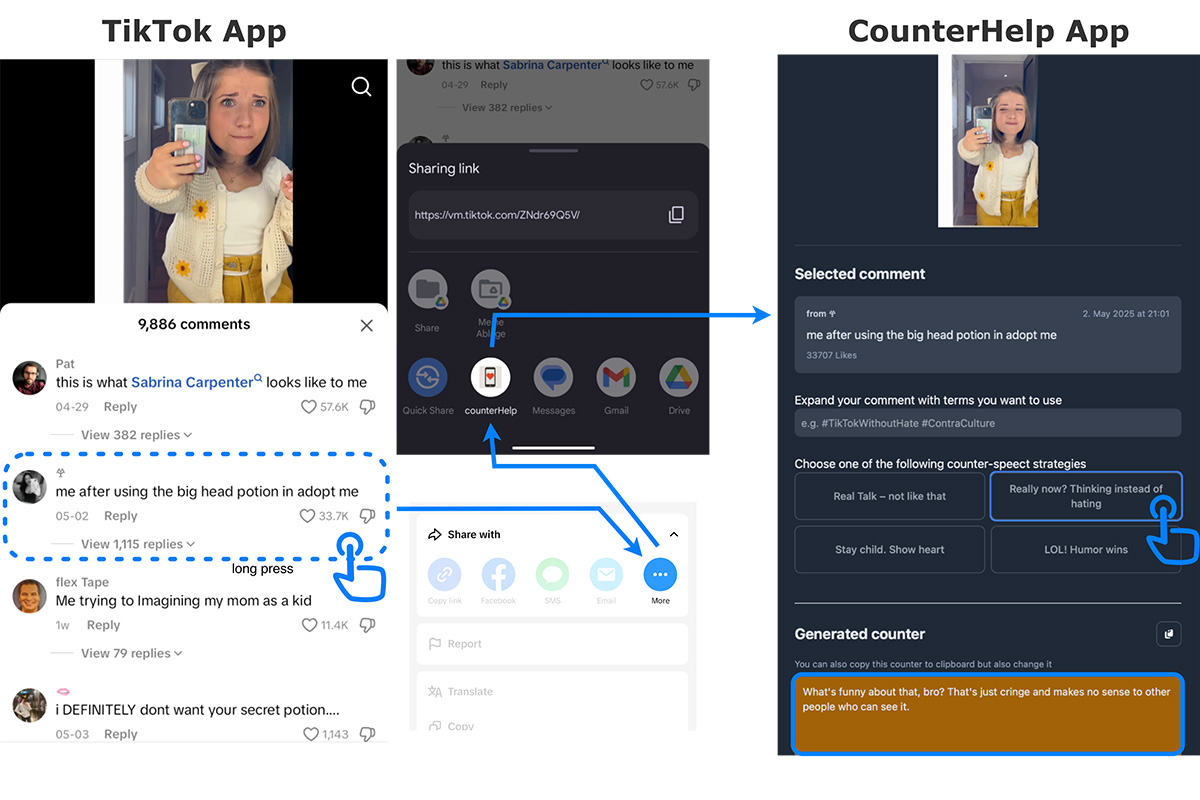

Konkreter wird das Projekt in Form der App CounterHelp, die Jugendliche beim Erstellen eigener Reaktionen auf TikTok unterstützt. Die Anwendung analysiert den ursprünglichen Kommentar und schlägt – in unterschiedlichen Tonlagen – passende Gegenrede vor: informativ, empathisch oder humorvoll.

Der Ansatz überzeugte auch international: Für die wissenschaftliche Umsetzung erhielt das Team den Best Interactive Experience Demo Award auf der Konferenz ACM Multimedia. Das zeigt, dass das Thema Hass im Netz längst nicht nur ein gesellschaftliches, sondern auch ein technologisches Innovationsfeld ist.

Parallel dazu wurde ein transparentes KI-Modell entwickelt, das Hass- und Gegenrede anhand nachvollziehbarer sprachlicher Konzepte erkennt – ein Versuch, Sprachanalyse verständlicher und damit vertrauenswürdiger zu machen.

Imitation Learning für deutschsprachige Räume

Während Counter Speech auf die Nutzerinnen und Nutzer setzt, verfolgt das Schwesterprojekt HaSPI – Hate Speech Prevention through Imitation einen stärker automatisierten Zugang. Unter Leitung von Sebastian Neumaier entwickelt die USTP Modelle, die Moderationsentscheidungen nachahmen sollen – gelernt aus großen Datensätzen, etwa dem One-Million-Posts-Corpus von derStandard.at.

Ziel ist ein Moderationssystem, das im deutschsprachigen Raum verlässlicher arbeitet als international trainierte Modelle, die häufig an Kontext, Ironie oder Sprachvarianten scheitern. Tobias Kietreiber, stellvertretender Projektleiter, sieht darin einen entscheidenden Schritt: Hasskommunikation sei nur dann maschinell erkennbar, wenn Systeme menschliche Bewertungslogik verstehen – nicht bloß Wörter zählen.

Forschung als Gegenentwurf zu Plattformlogik

Beide Projekte eint ein gedanklicher Kern: Hass im Netz lässt sich nicht allein durch technologische Härte bekämpfen, sondern durch eine Kombination aus automatisierten Werkzeugen, Medienkompetenz und sichtbarer digitaler Zivilcourage. Für Medienhäuser und Kommunikationsprofis ist das mehr als Forschung – es ist ein Hinweis darauf, dass Strategien gegen digitale Verrohung künftig hybrider werden müssen.

(PA/red)

Das könnte Sie auch interessieren

Wayback: Wozu das Internet-Archiv dient

Wie Medien-Webseiten KI-Crawler steuern